2025年12月、ChatGPTの画像生成は「きれいな絵が作れる」だけでなく、実際の制作フローに入り込みやすくなりました。OpenAIはこの新しい画像体験を「ChatGPT Images」として案内しており、画像生成モデルは「GPT-Image-1.5」と呼ばれています。ブログやSNSで使うなら、重要なのは次の5点です。待ち時間(スピード)、同じキャラクターを保てるか(一貫性)、気に入った画像を部分的に直せるか(部分修正)、文字が読めるか(英字・日本語)、そして仕上げ工程へつなげられるか(Adobe Expressなど)です。

この記事では、このポイントを含めて5つの検証を順番に見ていきます。評価はシンプルに、そのまま使えるか(実用性)と、待ち時間(制作テンポ)の2つで整理します。画像生成は同じ指示でも混雑や内容の重さで時間がぶれるため、待ち時間は「このくらいの傾向がある」という目安として扱います。

検証1|生成スピード:30秒と60秒台の差

画像生成を日常的に使うなら、スピードはかなり重要です。待ち時間が長いと「もう1回試す」が減り、結果として完成度も上げにくくなります。逆に短ければ、少しずつ直して理想に近づけやすくなります。

今回の検証では、同じ画像生成でも「指示の重さ」で待ち時間が大きく変わりました。

軽い指示:アニメ調の猫キャラは約30秒

まずはシンプルな指示です。

- ノートパソコンで作業している

- メガネをかけた茶トラ猫

- アニメ調でシンプルに

このタイプは、構図も単純で、写実的な質感表現も少ないためか、体感で約30秒ほどで生成できました。ブログの案内役キャラや、吹き出し用のイラスト素材を作るなら、このスピード感は十分実用的です。

重い指示:写真風+日本語文字は50秒〜1分5秒(同一プロンプト3回)

次に、負荷が上がりやすい条件を含む指示です。写真風の雰囲気に加え、看板に日本語(漢字+かな)を自然に入れるタイプは、どうしても処理が重くなります。

<プロンプト>昭和レトロな喫茶店の入口。木製看板を画面中央に大きく。看板の文字は崩さず、誤字脱字なしで、はっきり読めるように書く。 1行目「猫でもわかるChatGPT」 2行目「本日のおすすめ:プリンと珈琲」 写真風、自然光。

同じプロンプトで3回試したところ、生成時間は次の通りでした。

- 50秒

- 1分

- 1分5秒

最短50秒〜最長65秒で、差は15秒。平均すると約58秒です。ここは「速くなった/遅くなった」というより、内容が重いと待ち時間帯が上がり、さらにその中で揺れると捉えるのが現実的です。

結論:軽く作ってから、重い条件を足すのが効率的

スピード面でおすすめの使い方は、次の流れです。

- まず軽めの条件で叩き台を作る(構図・キャラ・雰囲気を決める)

- 良い土台ができたら、条件を足す(写真風、細かい質感、文字など)

- 最後に仕上げ(投稿サイズ、色味調整)へ進む

最初から条件を全部盛りにすると、待ち時間も修正回数も増えがちです。段階的に詰めると、テンポを保ったまま完成度を上げやすくなります。

検証2|一貫性:同じキャラで別シーン

ブログやSNSでキャラクターを使う場合、最初の1枚が良くできても終わりではありません。2枚目、3枚目を作ったとたんに別人(別猫)になると、シリーズとしての統一感が崩れます。ここが画像生成を「運用」に使うときの大きなポイントです。

今回は、同じ茶トラ猫キャラクターを作ってから、別のシーンに移しても“同じキャラ”として成立するかを確認しました。

実際に使ったプロンプト

① 1枚目(ベース生成)

「ノートパソコンで作業している、メガネをかけた茶トラの猫のキャラクターを描いて。アニメ調でシンプルに。」

② 2枚目(同じキャラのままシーン変更)

(画像が出たら続けて)

「その猫のキャラクターのまま、今度は外でカフェラテを飲んでいるシーンに変えて。顔や特徴は変えないでね。」

結果:特徴点が保たれやすく、運用の手応えあり

生成結果を見ると、同一キャラとして見せるために重要な要素が揃いやすい印象でした。特に分かりやすいのは次のような部分です。

- メガネの形(フレームの雰囲気)

- 茶トラ模様の出方(色のバランス)

- 目や口のタッチ(表情の空気感)

完全に同じ絵になるわけではありません。背景や光の雰囲気はシーンに合わせて変わることがあります。とはいえ、運用で困りやすい「顔つきが変わる」「模様が別物になる」といったブレは、以前より抑えやすく感じました。

うまくいかない時のコツ

今回のプロンプトは短くても成立しました。もしブレる場合は、次のように「固定したい要素」を一言足すと安定しやすくなります。

- メガネの形は同じ

- 模様の位置は同じ

- 線の太さ、塗りの雰囲気も同じ

検証3|部分修正:フルーツだけ差し替え

画像生成でありがちなのが「ここだけ直したいのに、全体が変わってしまう」問題です。部分修正が安定すると、画像生成は一気に実務寄りになります。

今回は、ケーキの上のフルーツだけを狙って差し替えられるかを確認しました。

実際に使ったプロンプト

① ベース生成

「豪華なバースデーケーキの画像を作って。トップにはイチゴがたくさん乗っているデザインで。」

② 部分修正(差し替え)

(画像が出たら続けて)

「そのケーキの上の『イチゴ』だけを、全部『シャインマスカット』に入れ替えて。他の部分は一切変えないで。」

結果:「変えないもの」を列挙しなくても、かなり狙い通りに

今回のケースは、細かい条件を並べなくても上手くいきました。

「他の部分は一切変えないで」という一文だけで、ケーキ全体の雰囲気を保ったままフルーツ差し替えが成立しやすい印象です。

この差し替えが使えるようになると、考え方が変わります。

- まず良い土台を作る

- 気になる部分だけ直す

- 完成度を少しずつ上げる

「一発で当てる」よりも、結果として速く仕上がることが増えます。

うまくいかない時のコツ

今回のように短い指示で決まることも多いです。もし全体まで動いてしまう場合は、次のように「変えない対象」を追加すると安定しやすくなります。

- 変えない:構図、背景、光、ケーキの形、装飾

この“補助輪”を使うかどうかは、結果を見てからで十分です。

検証4|文字:英字・日本語はどこまで読める?

画像生成の弱点としてよく挙がるのが「文字」です。雰囲気は良いのに、看板やロゴが読めない。スペルが崩れる。日本語だと特に漢字が怪しい。こうなると、ブログやSNSで“使える素材”にはなりません。

今回の検証では、英字(ネオンサイン)と、日本語(漢字+かな)の看板で、「はっきり読める文字」がどこまで通るかを確認しました。

英字ネオン「CAT AI NEWS」は正しく入る?

まずは英字です。指示したのは「サイバーパンク風のカフェの店内に、中央のネオンサインで『CAT AI NEWS』と書く。文字ははっきり読めるように」という内容でした。

英字の良いところは、短文で、しかも文字数が少ない点です。今回のケースでも、次の条件が揃っていたのが効いています。

- 文字が短い(CAT AI NEWS)

- 置く場所が明確(中央)

- 媒体が明確(ネオンサイン)

- 要求が明確(はっきり読めるように)

この4点が揃うと、モデル側も「装飾としての文字」ではなく「読ませる文字」として処理しやすくなります。結果として、看板やネオンのような“短いフレーズ”は、実用に近い精度で出せるケースが増えています。

文字が崩れにくいプロンプトの型(英字・日本語共通)

ここは読者が再現しやすいように、型としてまとめておきます。

- 文字は短く(まずは1〜2行まで)

- 置き場所を指定(中央、上部、看板の中央など)

- 媒体を指定(ネオン、木製看板、ポスター、ラベル)

- 「読めるように」を明記(誤字脱字なし、はっきり判読、など)

長文をいきなり狙うより、短文で成功パターンを作ってから伸ばしたほうが安定します。

日本語(漢字+かな)の看板はどうか

次は日本語です。ここが、ブログ読者にとって一番気になるところかもしれません。英字は通っても、日本語(特に漢字)が崩れると実用になりにくいからです。

今回の検証で試したのは、昭和レトロな喫茶店の入口にある木製看板です。文字は2行で、漢字+かなが混ざります。

- 1行目:「猫でもわかるChatGPT」

- 2行目:「本日のおすすめ:プリンと珈琲」

この条件で、短文の日本語を“看板として読める形”で出せるかを見ました。日本語の場合、漢字は画数が多く、崩れやすいポイントがいくつかあります。特に注意したいのは、次のようなところです。

- 「猫」「本日」など画数のある漢字が潰れないか

- 「珈琲」のような難しい漢字で誤字が出ないか

- 「おすすめ:」の記号や濁点が欠けないか

- 木目や影に埋もれて判読不能にならないか

今回の目的は、書体の美しさよりも「読めること」です。短文の看板として成立するなら、ブログのアイキャッチや小さな素材にも応用できます。実際に生成された画像はこちらです。

日本語文字の「差し替え」は実務に効く。ただし長くすると崩れやすい

日本語の文字が読めるだけでも十分すごいのですが、今回さらに実務的だったのが、文字の差し替え(更新)が成立した点です。看板のデザインや木目、店内の光や構図は維持したまま、2行目の文言だけを変更できました。

ブログやSNSでよくあるのは「同じデザインのまま、日付やメニュー、価格だけを更新したい」というケースです。ここが通ると、画像生成は「毎回ゼロから作る」から「土台を使い回して更新する」へ変わります。

実際に試した差し替え(短文):成功

まずは短めの文言で差し替えました。

差し替え指示(短文)

「看板の2行目を『本日のおすすめ:ナポリタン』に変更してください。看板の木目、文字の位置、書体の雰囲気、背景、光、構図は一切変えないでください。」

この結果、背景や木目はそのままに、2行目だけが狙い通りに変更できました。短い日本語テキストなら、「入れる」だけでなく「更新する」ところまで現実味が出てきています。

次に、もう少し“現実のメニューっぽい”文言にしてみました。

差し替え指示(長め)

「看板の2行目を『本日のおすすめ:手作りプリンと自家焙煎珈琲』としてください。」

すると、「自家焙煎珈琲」の部分が意図した表記にならない(漢字が崩れる/別の字になる)という結果になりました。たとえば「手作りプリン」が「子作りプリン」になったり、「手作りブリン」になったりして、「自家焙煎」も安定しにくい印象です。

短文では通っても、文字数が増えたり、画数の多い漢字が続いたりすると、精度が落ちることがあります。

ここがポイントです。

今回の検証で分かったのは、ChatGPT画像生成の文字は「読める」段階に来ている一方で、長めの日本語(特に難しい漢字が続く文言)では、まだ表記の揺れが残るということです。

使い分けの結論|画像内の文字は「短く」、長文はツール側で確実に

ブログやSNS用途で現実的なのは、次の使い分けです。

- 画像生成内で文字を入れる:短いタイトル、見出し、ラベル向け(短文なら実用になりやすい)

- 長文の本文、細かい注釈:デザインツール側で入れる(確実)

「短文は任せる、長文は後入れ」と割り切っておくと、文字が崩れても制作が止まりません。文字の“最後の確実性”は、現時点ではAdobe Expressなどのツール側が強いです。

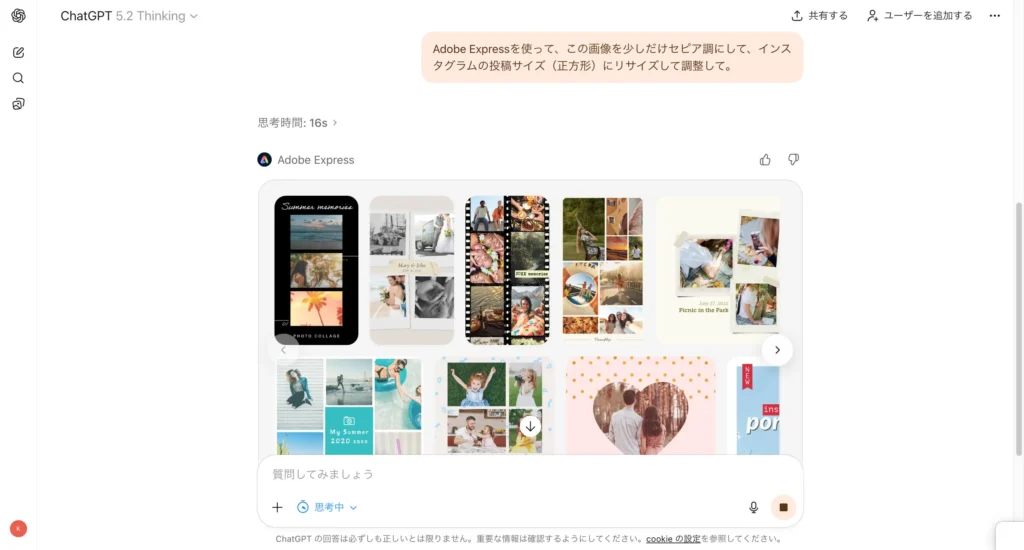

検証5|Adobe Express:開けた/自動加工は未対応

画像生成が実用に近づくと、次に気になるのが「仕上げ」です。ブログやSNSで使う場合、最終的には投稿サイズに整えたり、色味を少し調整したりする場面がよくあります。そこで今回は、ChatGPT内からAdobe Expressを呼び出して仕上げ工程につなげられるかを確認しました。

結論から言うと、連携自体は動きました。 ただし、イメージしていた「ChatGPTがAdobe側でフィルター適用やリサイズまで実行して書き出す」ところまでは、少なくとも今回の検証環境では確認できませんでした。その代わりに、作業を前に進めるための“2つのルート”が用意されていました。

何をお願いしたか(やりたかったこと)

指示したのは次の内容です。

- いまの画像を「少しだけセピア調」にしたい

- Instagram投稿サイズ(正方形 1080×1080)にリサイズしたい

- できれば、そのまま投稿できる形で書き出したい

仕上げとしては、よくある作業です。写真の雰囲気を少し変え、サイズを整える。これが一気にできるなら、画像生成の使い勝手はさらに上がります。

連携は開いた(この画面が出た)

実際には、ChatGPT内にAdobe Expressの画面が表示され、連携は成立しました。少なくとも「連携できなかった」わけではありません。ここは大事なポイントです。

ただし、その直後に表示された説明が重要でした。

「こちらで実行して書き出す」までは未対応だった

表示された内容は要約すると、こういうことです。

ChatGPT内のAdobe Express連携では、

画像そのものに「セピア調フィルターをかける」

「任意サイズにリサイズ(今回なら1080×1080)」

を“こちらで実行して書き出す”ところまでは、まだ対応していない

つまり、Expressを呼び出す入口はあるものの、処理を完全に自動化して完了させる段階には達していなかった、ということです。

代替ルートが2つ提示された(ここが実用的)

未対応で終わりではなく、その代わりに2つの方法が用意されていました。

1)いますぐ投稿できる完成データ(こちらで加工済み)

「少しだけセピア調(弱め)」に寄せたうえで、Instagram投稿サイズ(1080×1080)に整えたデータを、ダウンロードできる形で提示してくれました。形式はJPGとPNGの2種類です。

- 少しだけセピア調(弱め)

- 1080×1080(正方形)

- JPG/PNGで受け取れる

“自動でExpress側の処理を実行”はできなくても、投稿用素材として成立するデータが出るなら、実務的には助かります。

2)Adobe Expressで同じことをやる手順(Edit in Express)

もう一つは、Express側で仕上げる手順の案内です。下の「Edit in Express」からテンプレを開き、Express上で同じ作業を行う流れでした。こちらは、後から微調整したい場合に向きます。

案内されていた最短手順は、ざっくり次の通りです。

- テンプレを開く

- 画像枠をクリック →「置き換え(アップロード)」で画像を入れる

- 左メニューの調整/エフェクト(フィルター)で薄セピアに近づける

- Sepiaがあれば弱めに

- なければ彩度を少し下げる+暖かさ(色温度)を少し上げる

- リサイズ →「Instagram投稿(正方形)」=1080×1080

- 書き出し(JPG推奨。文字のキレ優先ならPNG)

このルートの良い点は、画像を見ながら強さを調整できるところです。「少しだけセピア」の“少し”は人によって違うので、最終調整が手元でできるのは安心です。

ここでわかった“役割分担”

今回の挙動から見えるのは、全部を自動化してくれる万能連携、というより、次のような役割分担です。

- ChatGPT:叩き台づくり、投稿用サイズの素材生成、手順の案内

- Adobe Express:仕上げの微調整、レイアウト、確実な書き出し

つまり、連携は入口として機能するが、最終仕上げはツール側で詰める、という流れが現実的です。ここを割り切ると、画像生成の使い道が整理しやすくなります。

まとめ

今回、スピード/一貫性/部分修正/文字(英字・日本語)/Adobe Express連携という5つの観点で確認しました。結論として、ChatGPTの画像生成は「一発で当てる」より、叩き台を作って必要な部分を直しながら仕上げる使い方に向いてきています。

中でも実務的だったのが、文字の扱いです。短いフレーズであれば、画像内に読める文字を入れられるだけでなく、作った画像の雰囲気や背景を保ったまま、文言の一部だけを差し替えて更新できました。これができると、同じデザインを土台にして「日付」「メニュー」「キャッチコピー」だけを入れ替える運用が現実的になります。特に「短い文字→差し替えで更新」まで通ると、画像生成は“単発”ではなく“運用”として回しやすくなります。

仕上げについては、ChatGPT内からAdobe Expressを開けました。一方で、セピア適用や1080×1080への書き出しを“こちらで実行して完了”までは未対応でした。その代わり、投稿用サイズに整えた加工済みデータの提示や、Express上での最短手順の案内が用意されていました。現時点では ChatGPT=素材づくりと案内/Express=仕上げ と役割分担して使うと迷いません。

※本記事は執筆時点で確認できた情報に基づいています。画面表示(UI)や利用条件は変更される場合があります。最新情報は各公式サイト・利用規約をご確認ください。

💡 同じカテゴリーの関連記事です(近いテーマを優先しています)