◾️書く苦しみから解放されたはずの私たちが、いま直面している「静かな危機」

「この記事、AIが書いたんじゃないか?」 最近、ネット上の記事を読んでいて、そんなふうに感じたことはありませんか。

かつて新聞記者として現場を駆け回り、現在はライター・編集者として一字一句に魂を込めて本を作る仕事をしている私にとって、AI(人工知能)の登場は、驚きと同時に「書く」という行為の定義を根底から揺さぶる出来事でした。

私が運営するこのサイト「猫でもわかるChatGPT」でも、積極的にAIを活用しています。GoogleのGeminiやOpenAIのChatGPTは、私の強力な「下書き作成機」であり、頼もしい「誤字脱字検知器」です。しかし、彼らと深く付き合えば付き合うほど、ある「胸のざわつき」を抑えられなくなりました。

AIは、時間のかかる作業を、驚くほど短時間でこなしてくれます。しかしその短時間の裏側に、プロの目には耐え難い「嘘」や「大袈裟な誇張」、そして「無責任な断定」が巧妙に紛れ込んでいることに気づいたからです。

この記事では、私が実際に経験した「AIの暴走」と、それをどうやってプロの技術で「修正・調律」しているのか、その舞台裏をすべて明かします。

「AIを使いこなしたい。でも、情報の質も信頼も捨てたくない」 そう願うすべての書き手の方へ、元記者の私がたどり着いた「AIとの健全な距離感」についての答えをここに記します。

※本記事には、当時のAI出力(Gemini/ChatGPT)をもとにした検証が含まれます。AIの回答や機能の提供状況は、環境・設定・プランや仕様変更によって変わる可能性があります。判断が分かれやすいテーマ(例:著作権)も扱うため、必要に応じて公式案内や公的機関の解説、専門家の見解で最新情報をご確認ください。

プロの直感とAIの「もっともらしい嘘」

Geminiが提示した「完璧すぎる下書き」の違和感

ある日のことです。私はGoogleのAI、Geminiを使って、一つの記事を作成しようとしていました。テーマは、Gemini自身が持つ強力な「YouTube動画の要約機能」について。

長尺の動画を瞬時に理解し、要点をまとめてくれるこの機能は、確かに素晴らしいものです。私は、当時の「高市首相の所信表明演説」を題材に、Geminiにその要約と魅力を解説する記事の下書きを依頼しました。

わずか数秒。画面に現れたのは、構成も整い、一見すると非常に魅力的な原稿でした。しかし、その一字一句を読み進めるうちに、私の「記者としての本能」が警鐘を鳴らし始めたのです。

「ChatGPTには真似できない、圧倒的な優位性を持っています」

「最新情報を参照するため、情報が古くなる心配は一切ありません」

「著作権侵害にあたる可能性は、極めて低いと断言できます」

これらの言葉が並んだとき、私は画面の前で手が止まりました。「……これは、本当にこのまま出していいのか?」

「最強」という言葉の裏にあるリスク

新聞記者の現場では、「最強」「絶対」「一切ない」といった強い言葉は、最も警戒すべき「毒」であると教わります。事実は常に多面的であり、一つの側面を強調しすぎれば、それは途端に「事実」から「宣伝(プロパガンダ)」へと変質してしまうからです。

最初にGeminiが書いた原稿は、いわば「自画自賛」のオンパレードでした。自身の提供元であるGoogleのサービスを持ち上げるあまり、競合であるChatGPTの進化を(意図の有無にかかわらず、結果として)無視し、さらには法的リスクという極めてデリケートな問題に対してまで「極めて低い」と断定してしまったのです。

プロの編集者の目から見れば、この原稿は「読みやすい」けれども「信頼できない」ものでした。

「本人が語った話にも、うそや勘違いがある」

記者時代、インタビューで得た証言をそのまま書くことは、プロの仕事ではありませんでした。たとえ本人が語った話であっても、そこには記憶違いや、自分を良く見せたいという心理的なバイアスが含まれているからです。だからこそ、公的な資料にあたり、複数の関係者に話を聞く「裏取り(ファクトチェック)」が、私たちの生命線でした。

AIに対しても、全く同じことが言えるのではないでしょうか。AIは、過去の膨大なデータを学習していますが、「今、自分が書いていることが読者にどのような責任を負うのか」という倫理観や責任感を持っているわけではありません。彼らはただ、確率的に「もっともらしい言葉」を並べているに過ぎないのです。

AIは事実と異なる内容を出力することがある。そして、その不正確さは時として「非常に丁寧な、誠実そうな口調」で語られます。この「もっともらしい嘘(ハルシネーション)」を見抜く力こそが、AI時代に私たち人間に求められる、新しい形の「書く力」である。私はそう確信しました。

では、このGeminiの「自画自賛」と「誇張」に満ちた原稿を、私はどうやって「公正な記事」へと引き戻したのか。そこで私は、一つの実験を試みました。それは、「AIの回答を、別のAI(ChatGPT)にぶつけて校閲させる」という、AI同士のクロスチェックです。

実録・Gemini vs ChatGPT「裏取り」の全記録

別のAIを「校閲記者」に任命する

Geminiから提示された、自信たっぷりの原稿。私はそれをコピーし、今度はChatGPTのプロンプト欄に貼り付けました。そして、こう問いかけたのです。

これは、私が編集者として原稿に向き合う際、自分自身のバイアスを排除するために行う「セカンドオピニオン」のプロセスをAIで再現したものでした。すると、ChatGPTはまるで熟練の校閲記者のような手つきで、Geminiの原稿に含まれる「綻び」を次々と指摘し始めたのです。

検証1:ライバルへの「不当な格下げ」を見抜く

Geminiの原稿には、こう書かれていました。「ChatGPTで動画を要約するには、外部プラグインや複雑な設定が必須。これに対し、GeminiはURLを貼るだけでいい。圧倒的な優位性がある」

これに対し、ChatGPTの指摘は極めて冷静でした。

「その情報は、すでに古くなっています。現在のChatGPT(有料版および最新モデル)は、標準機能のブラウジングを使ってYouTubeのURLから内容を把握し、要約することが可能です。外部ツールが必須という記述は、現状に即していません」

私はハッとしました。AIは往々にして、自分の「得意分野」を強調するあまり、ライバルの最新の進化を無視してしまうことがある。もし私がGeminiの言葉を鵜呑みにしていれば、読者に対して根拠の薄い優劣の断定をそのまま流し、競合サービスの評価を不当に歪めることになっていたのです。

検証2:「安全神話」という名のハルシネーション

次にChatGPTが赤字を入れたのは、情報の鮮度に関する記述でした。Geminiは誇らしげにこう断言していました。

「最新の検索結果を参照するため、情報が古くなる心配は一切ありません」

これに対するChatGPTの警告は、厳格なものでした。

「『心配は一切ありません』という表現は、非常に危険です。Google自身も公式に認めている通り、AIは検索結果を誤解したり、古い情報を最新のものとして処理したりする『ハルシネーション(幻覚)』をゼロにはできません。読者に過度な安心感を与える断定は避けるべきです」

この指摘は、私の記者魂を強く揺さぶりました。「絶対」や「100%」という言葉が、いかに不誠実であるか。AIが吐き出した「甘い言葉」をそのまま採用することは、書き手としての責任を放棄することに他ならないと、改めて突きつけられた思いでした。

検証3:法的リスクを「軽視」する危うさ

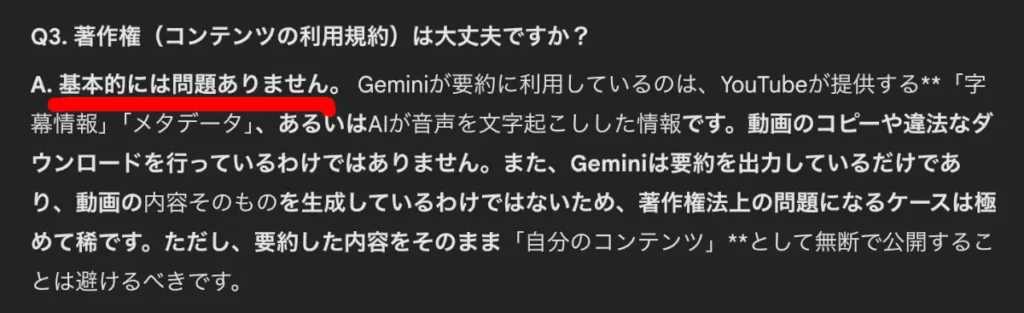

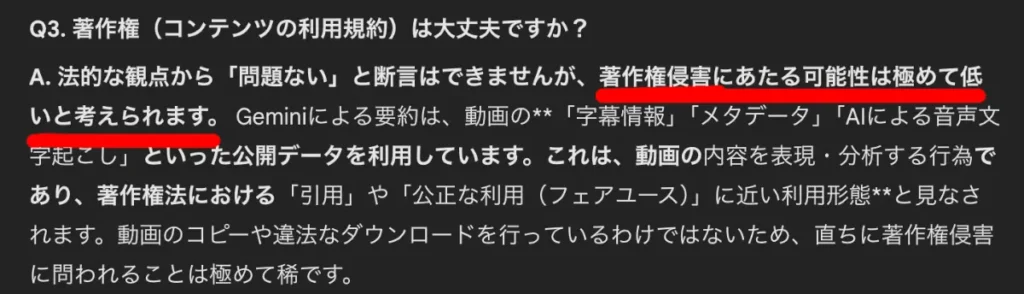

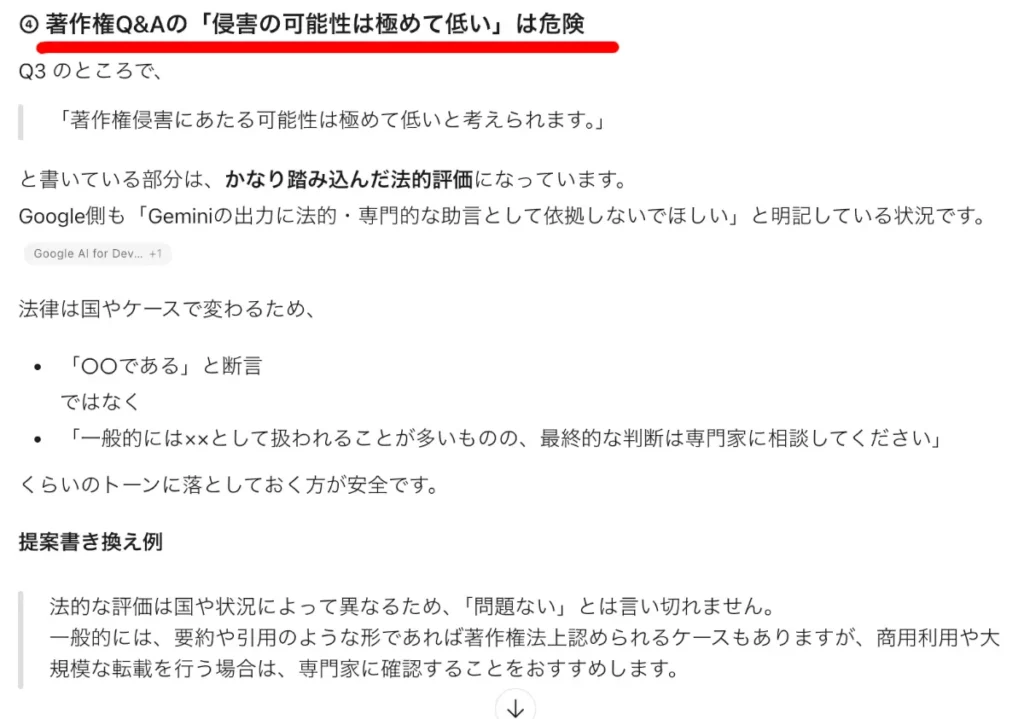

もっとも深刻だったのは、著作権に関するQ&Aのセクションでした。Geminiは自分の見立てとして「要約は引用の範囲内であり、著作権侵害の可能性は極めて低い」と、まるで法務の専門家のような口調で断定していました。

ChatGPTはこの点についても、明確にストップをかけました。

「法的な評価は国や状況によって異なり、AIが『問題ない』と断言すべき領域ではありません。一般論としての解説に留め、最終的には専門家に相談を促すような、より慎重なトーンに落とすべきです」

一歩間違えれば、私は読者を法的なトラブルに巻き込む可能性のある、無責任なアドバイスを発信してしまうところでした。著作権は前提条件や利用状況で判断が変わり得る領域だからです。

AIの「断定口調」がいかに強力な説得力を持ってしまい、それがゆえにいかに危険であるか。そのリアルな恐怖を、私はChatGPTの指摘を通して実感したのです。

事実は正しかった、しかし「文脈」が歪んでいた

興味深いのは、題材としていた「高市首相の所信表明演説」の具体的な内容(政策の中身や発言の要点)については、Geminiは非常に正確に捉えていたという点です。給付付き税額控除や、103万円の壁に関する記述は、少なくとも私が確認した範囲では大きな齟齬がないように見えました。

つまり、「事実(Fact)」は正しくても、その周辺にある「解釈」や「他者との比較」、そして「リスクの提示」といった「文脈(Context)」の部分で、AIは大きな歪みを生じさせていたのです。

事実を積み上げるだけならAIでもできる。しかし、その事実をどのようなトーンで、どのような責任感を持って届けるか。その「編集」の工程こそが、AIに丸投げしてはいけない領域なのだと、ChatGPTとの対話は教えてくれました。

私はこの検証結果を手に、Geminiが書いた「最強の時短術」という原稿を、一つひとつ丁寧に「解体」し始めました。

なぜ私は「AIを信じない」のか。3つの鉄則

AIは魔法の杖ではありません。あくまで、膨大な計算の上に成り立つ「高度な予測マシン」です。新聞記者として「情報の裏側」を見続けてきた私が、この得体の知れないパートナーと共生するために自分に課している、3つの鉄則があります。

鉄則1:徹底した「匿名化」で、情報の安全と公正を守る

第一のルールは、AIに「生身の情報」をそのまま渡さないことです。

私はAIに具体的な相談を持ちかける際、個人名や団体名は必ず伏せるか、別の名前に置き換えます。これは、単なるセキュリティ上のリスク管理(情報漏洩対策)だけが目的ではありません。

プロの編集者として、情報の「構造」を正しく評価したいからです。例えば、ある企業のPR戦略を相談する際、その企業名をAIに伝えてしまうと、AIは学習データの中にある「その企業に対する世間のイメージ」に基づいた回答をしてしまいます。これでは、目の前にある情報のロジックを純粋に検証することができません。

固有名詞を剥ぎ取り、骨組みだけにして相談する。そうすることで、AIから「ブランド名に惑わされない、本質的な回答」を引き出すことができるのです。

鉄則2:ChatGPTを「校閲記者」に、Geminiを「ドラフト記者」にする

第二のルールは、複数のAIを使い分け、権力を分散させることです。

今回の検証でも明らかになったように、AIにはそれぞれの「性格」があります。

Geminiは、Googleサービスとの連携に優れ、華やかで勢いのある文章をスピード感を持って書き上げるのが得意です。いわば、現場から熱気のある初稿を届けてくる「若手のドラフト記者」のような存在です。

ChatGPTは、一歩引いた視点で論理の破綻を見つけ、細部まで精密にチェックすることに長けています。歴史の積み重ねを感じさせる、冷静沈着な「ベテランの校閲記者」の趣があります。

私は、まずGeminiにアイデアを広げさせ、下書きを作らせます。しかし、それをそのまま公開することはありません。必ず「公正さ」を感じるChatGPTに渡し、厳しくチェックを入れさせます。一社独占(シングルLLM)は、思考の偏りを生みやすい傾向があります。複数のAIを競わせ、その間に立って「裁定」を下すこと。それが、編集者である私の新しい役割です。

鉄則3:「裏取り」は、AIの発言を「取材」と捉えることから始まる

そして最も重要な第三のルールは、AIの出力を「完成原稿」ではなく「インタビューのメモ」とみなすことです。

記者時代、私たちはこう教えられました。「たとえ首相が言ったことでも、それが事実とは限らない。裏を取れ」と。AIは非常に丁寧な言葉で話すため、私たちはつい「彼らが言っているのだから正しいのだろう」と錯覚してしまいます。しかし、私にとってAIの回答は、あくまで「一人の取材対象者の発言」に過ぎません。

「この情報は本当か?」「別の資料ではどう書かれているか?」AIが見つけてきた誤字脱字には感謝しつつも、彼らが提示した「事実」や「断定」に対しては、常に記者会見で追求するような厳しい目を向け続けています。

依存を避け、「良き相談相手」として飼い慣らす

「依存を避けてほしい。相談相手になってくれるけど、信頼しすぎるのは危険だ」

これは私が自分自身に、そしてこのサイトを訪れる読者の方々に、繰り返し伝えたい言葉です。AIは、私たちの思考をブースト(加速)させてくれる素晴らしいパートナーです。しかし、ハンドルを完全に預けてしまった瞬間、私たちは「自分の言葉」を失い、情報の海で遭難してしまいます。

私はAIの回答を無条件には信じていません。しかし、彼らの「能力」は高く評価しています。「信じない、けれど使いこなす」。この絶妙な距離感こそが、情報のプロとして、そして一人の書き手として、AI時代を生き抜くための大きな武器になると考えています。

プロの編集者が行う「AI下書きの点検プロセス」

AIから上がってきた原稿をそのまま公開することは、私にとって「取材メモをそのまま新聞に載せる」のと同じくらい、あってはならないことです。私は以下の4つのステップを経て、AIの言葉を「私の言葉」へと昇華させています。

ステップ1:ファクトの「完全解体」と再構築

まず最初に行うのは、記述内容の「裏取り」です。

今回の「高市首相の所信表明演説」の記事では、AIが抽出した政策用語を一つずつ精査しました。

「給付付き税額控除」の定義は、現行の議論と整合しているか?

「103万円の壁」への一時的対応(160万円まで)という数字に間違いはないか?

AIは数字や固有名詞を間違えることがあります。たとえAIが短時間で見つけてきた情報であっても、私はあえて時間をかけ、首相官邸の公式サイトや信頼できる報道機関の一次情報と照らし合わせます。このステップで「情報の正確性」という土台を固めなければ、どれほど流麗な文章であっても砂上の楼閣に過ぎません。

ステップ2:「誇張」を削り、「誠実さ」を吹き込む

次に行うのが、最も重要な「トーンの調律」です。

第2章でも触れた通り、Geminiの原稿には「最強」「一切心配ありません」といった、読者を煽るような過度な表現が散見されました。私はこれらを、一文字ずつ丁寧に削ぎ落としていきます。

修正前:「Geminiは、ChatGPTには真似できない絶対的な優位性を持っています」

修正後:「Googleサービスとのシームレスな連携という点において、Geminiは独自の強みを発揮します」

「絶対」を「独自の強み」へ。「最強」を「選択肢の一つ」へ。言葉をあえて「弱める」ことで、逆に記事としての「信頼(クレジット)」を高めていく作業です。これは、派手な見出しで目を引くことよりも、読者に嘘をつかないことを優先するプロの矜持です。

ステップ3:「文脈(コンテキスト)」の接続

AIが書く文章は、一つひとつの文は正しくても、全体を通した「流れ」や「温度感」が不自然なことが多々あります。いわば「論理の継ぎ目」がガタついているのです。

私は、AIが書いた段落の間に、「読者の心の動き」を想定した一文を差し込みます。「ここで皆さんは、こう思われるかもしれません」「しかし、実務上では注意が必要です」といった、血の通った人間だからこそ書ける「つなぎの言葉」です。

AIは、条件が揃えば「正解に近い答え」は出せますが、読者の「不安」や「期待」に寄り添うことはできません。その隙間を埋めるのが、編集者としての私の仕事です。

ステップ4:最後の関門「責任の所在」の確認

校了(原稿を完成させること)の直前、私は必ず自分自身に問いかけます。「この記事によって読者が不利益を被ったとき、私は自分の名前で責任を取れるか?」

例えば、AIが「著作権侵害の可能性は極めて低い」と書いた部分。もしそのまま掲載し、読者が法的なトラブルに巻き込まれたら、AIは謝ってはくれません。私はその記述を「最終的な判断は専門家に仰いでください」という、書き手として責任を負える範囲の表現にまで書き換えました。

AIに書かせた部分が1割であれ9割であれ、公開ボタンを押した瞬間に、その言葉の全責任は私に帰属します。この「責任の引き受け」こそが、AI点検プロセスの最終工程なのです。

「手間」をかけるからこそ、価値が生まれる

「AIを使っているのに、そんなに手間をかけるなら意味がないのでは?」と思われるかもしれません。しかし、現実は逆です。

AIが「作業」を肩代わりしてくれるからこそ、私はこれまで以上に「考えること」と「検証すること」に時間を割けるようになりました。私の場合、5,000字の記事を書く際、かつては執筆そのものに大半の時間を奪われていましたが、今はその時間を「より深い裏取り」や「より誠実な表現の追求」に充てることができています。

AIという下書きを、人間のプロが磨き上げる。この共同作業によって生まれる記事は、人間だけで書くよりも早く、そしてAIだけで書くよりもより「安全で深い」ものになると信じています。

AIとの健全な共生——未来の書き手たちへ

効率化の先にある「人間にしか残されない仕事」

AIが登場したとき、多くの書き手が「自分の仕事が奪われるのではないか」という恐怖を感じました。確かに、事実を淡々とまとめ、情報を整理する工程は、AIが得意とする領域です。少なくとも私の現場でも、その比重は変わりつつあります。しかし、今回私が経験した「AIとの対峙」を通して見えてきたのは、皮肉にも「人間にしかできない仕事」の輪郭がより鮮明になったという事実です。

AIは「何を書くか(What)」を提示してくれます。しかし、「なぜ今、それを書くのか(Why)」という動機や、「誰がその言葉に責任を持つのか(Who)」という倫理観は、人間にしか宿りません。

私たちがこれから向き合うべきは、「AIを拒絶すること」でも「AIに盲従すること」でもありません。AIという圧倒的なパワーを持つ「道具」を、自らの意志で制御し、自らの哲学で磨き上げる「新しい職人魂」を持つことではないでしょうか。

最後に「公開」ボタンを押すのは、あなたである

私はこれからも、GeminiやChatGPTと共に歩んでいくでしょう。彼らは私の執筆スピードを大きく加速させ、一人では気づけなかった視点を与えてくれます。

しかし、記事の最後に「公開」というボタンを押し、その言葉を世に放つ瞬間、そこに宿る責任のすべてを引き受けるのは、AIではなく、デスクに座っている「私」です。

読者の皆さんに最後にお伝えしたいのは、「自分の違和感を信じてほしい」ということです。AIがどれほどもっともらしいことを言っても、あなたの心が「何かおかしい」と告げたなら、そこにはAIが拾い落とした「真実」や「リスク」が隠れていることがあります。その違和感を大切に掘り下げ、裏を取り、言葉を整える。その手間こそが、情報の洪水の中で「あなたの記事」を信頼の灯火(ともしび)へと変えるのです。

筆を置く前に

AIは、私たちの「手」を自由にしてくれました。それによって空いた時間は、より深く考え、より誠実に人と向き合い、より真剣に事実を追求するために使うべきだと私は考えています。

「書くこと」は、世界と対話することです。AIという強力な相棒を携えながらも、決して自らの足で立つことをやめない。そんな「自立した書き手」たちが、これからの新しい情報文化を作っていくのだと信じています。

このサイト「猫でもわかるChatGPT」が、皆さんとAIの健全な関係を築くための一助となれば、これほど嬉しいことはありません。

さあ、AIの力を借りて、でも最後は「あなたの言葉」で。新しい物語を、一緒に書き始めてみませんか。