「文章から映像が作れる」——そんなAI体験を、もう試したことがある人もいるかもしれません。

2024年にChatGPTの機能として登場した初代Soraは、テキストから短い動画を作ることができる実験的なモデルでした。

そして2025年秋、進化版の 「Sora 2」 が登場。今回は、ChatGPTの一部機能ではなく、独立したiOSアプリ版とWeb版(sora.com) を中心に提供されています。

OpenAIアカウントは共通ですが、ChatGPT本体の画面から直接生成する機能は現時点では未実装。

ユーザーから見た体験としては、“ChatGPTから独立した動画生成アプリ”という印象に近くなっています。

Sora 2の最大の進化は、映像の精度だけでなく、音声や効果音の自動生成・カメラワークの自然さが加わったこと。

数行のプロンプト(指示文)を入力するだけで、まるで短編映画のような動画が完成します。

私も実際に試してみました。

テーマはもちろん——「屋上で踊る猫たち」。

毛並みの揺れ、夕暮れの光の反射、低いアングルからのズーム。

その完成度は「これ、本当にAIなの!?」と声が出るほど。

この記事では、Sora 2を実際に使ってみた体験と、

- Sora 2がどんなAIなのか(前作との違い)

- 料金と利用条件(利用できる範囲と注意点)

- 面白い猫動画を作るプロンプト設計のコツ

- 実際に生成して感じたポイント

を、「猫でもわかる」トーンでやさしく解説します。

AI動画の世界がどう進化しているのか、一緒に見ていきましょう。

※本記事は執筆時点で確認できた情報に基づいています。画面表示(UI)や利用条件は変更される場合があります。最新情報は各公式サイト・利用規約をご確認ください。

Sora 2とは?ChatGPTから進化した“映像生成AI”

文字から画像が生まれた次は、文字から映像が生まれる時代へ。

そんな流れを象徴するのが、OpenAIの最新モデル「Sora 2」です。

初代SoraはChatGPTの機能として静かに登場しましたが、

今回のSora 2は、まるで映画制作アプリのように独立。

現在は Soraアプリ(iOS) と Web版(ログイン: sora.chatgpt.com / ライブラリ: sora.com) を通じて順次提供されています。

ChatGPTと同じOpenAIアカウントでログインでき、数行の文章から「動く世界」を描けるようになりました。

OpenAIアカウントはChatGPTと共通ですが、動画生成はSora専用の画面で行います。

つまりChatGPTの中で動くAIではなく、ChatGPTと並ぶ“映像生成の主役”として進化したのです。

できること・特徴(要点)

- テキスト→映像+音:文章からショートムービーを生成。環境音・効果音が自動でつくケースもあります。

- 構図・カメラの理解が進化:低いアングル、スローモーション、パン/ズームなどの指示が通りやすい。

- 質感と光の表現:毛並み、反射、夕景の色などの“質感”がリッチに。

- 使い方がシンプル:アプリ/Webでプロンプトを入れて待つだけ。失敗したら書き直して再生成。

- 提供形態:Soraアプリ(iOS)/Web(ログイン:sora.chatgpt.com、ライブラリ:sora.com)から利用可能。現在は順次ロールアウト中。

📝 今回の実測(私の環境)

生成時間は 2分42秒、出力は 約10秒 の動画でした。初代Sora(5秒動画が“1分かからず”完成)と比べると待ち時間は伸びましたが、音声までのついていることを含めると、完成度は一段上。特に音の同期とカメラの自然な追従が顕著で、AI特有の不安定さはほとんど感じませんでした。

初代Soraから変わったところ(体感ベース)

- 体験の導線:ChatGPTの機能の一部から、アプリ/Web中心の利用へ。

- 演出の通りやすさ:カメラ指定(low angle/slow motion など)が以前より素直に反映。

- 自然さ:毛並み・反射・影の整合性が上がり、カット間の“つながり”も良く見えることが増えました。

- 音が加わった:静止感のある映像でも、環境音が入ると一気に“映画っぽさ”が出ます。

⚠️ 注意

提供地域や生成上限(ローリング24時間の利用回数など)は段階的に変わることがあります。公開前に一度、アプリ/Web内の案内を確認しておくと安心です。

料金と利用条件:利用できる範囲と注意点

Sora 2は、OpenAIが提供する動画生成AIです。

現在は順次ロールアウト中(Rolling out now)で、アカウント単位のローリング24時間上限(24時間ごとの生成回数制限)が設けられています。

iOSアプリまたはWeb版(sora.chatgpt.com)から利用でき、ChatGPTと同じOpenAIアカウントでログイン可能です。

利用条件や生成上限は今後変更される可能性があるため、最新情報はアプリ/Web内のお知らせを確認しましょう。

⚠️ 注意点と補足

- 提供地域

段階的に開放が進んでいます。アクセス可能な地域・アカウントは順次拡大中のため、最新の提供状況は sora.chatgpt.com または公式アプリ内のお知らせで確認してください。 - 商用利用について

OpenAIの規約により、生成した動画を広告・販売・配信に使う際は条件があります。

公開する前に、必ず最新の利用規約を確認しましょう。 - ウォーターマークとメタデータ

すべての出力動画には、可視ウォーターマークとC2PAメタデータが自動で付与されます(公式仕様として明示)。

これは改変・誤用防止を目的としたもので、今後も維持される見込みです。 - 出力形式

動画はMP4形式で保存されます。再生できない場合は、H.264形式に変換すれば多くの環境で再生可能です。なお、Soraでは音楽・効果音・セリフが自動で付与される場合があります(プロンプトで指定することも可能です)。

Sora 2の基本操作:動画を作るまでの流れ

Sora 2の魅力は、専門知識がなくても直感的に操作できること。

初代Soraと同様に「テキストを打ち込むだけ」で映像が生成されますが、

今回は操作画面や生成の流れがよりシンプルに整理され、動画制作アプリとしての完成度が一気に上がりました。

ここでは、実際に私が使って感じた“動画ができるまで”の流れを紹介します。

🪜 Step 1:Sora(Web/アプリ)にアクセスする

現在、Sora 2は Web版(ログイン:sora.chatgpt.com / ライブラリ:sora.com) と iOSアプリ版 の2つの形で提供されています。

OpenAIアカウントでログインすれば、どちらからでも利用できます。2025年10月時点では順次ロールアウト中です。

💡補足:

現在の主な導線はSoraアプリとWeb版のみです。

ChatGPT内の「Videoモード」などから直接生成する機能は公式には提供されていません。

<Web版の画面>

<iOSアプリ版の画面>

✍️ Step 2:プロンプト(指示文)を入力する

動画のテーマやシーンを日本語でそのまま入力します。Sora 2は日本語理解が大幅に進化しており、構図・光・動作・感情まで自然に読み取ってくれます(初期のように英語が必須ではありません)。

<例>

💡 実際の生成例(猫ダンス動画)では、こうした構成をもう少し詳しく書いたプロンプトを使用しました。

⏳ Step 3:生成を待つ(約2〜3分)

プロンプトを送信すると、Sora 2が映像生成を開始します。

処理時間は動画の長さや混雑状況によって変わりますが、平均で 2〜3分。

生成中はプログレスバーが表示され、完了後にプレビューが自動再生されます。

私の猫ダンスバトル動画では、約2分42秒で生成が完了しました。

短いながらも、照明の反射や毛並みの揺れ、スローモーション演出などがしっかり表現されていました。

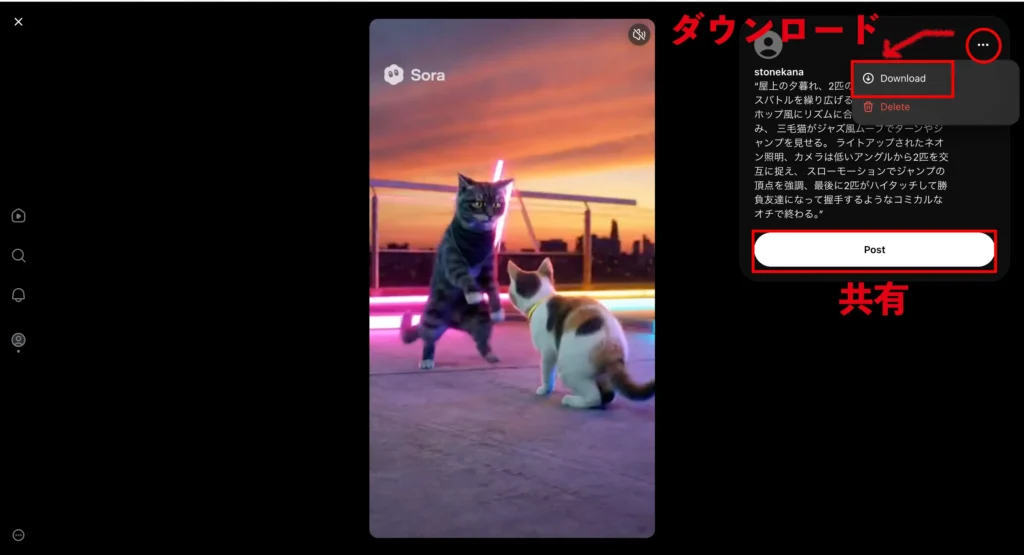

💾 Step 4:保存・共有する

右サイドの3点リーダーから「ダウンロード」、または「Post」を選択すれば完了。

出力はMP4形式で、SNS投稿やブログ(WordPress)にもそのまま使えます。

⚠️ 注意

出力はMP4形式です。環境によっては再生互換性に差が出るため、再生できない場合はH.264へ変換すると安定します。(MacはQuickTime、WindowsはHandBrake など)

🎨 まとめ:本当に“打つだけでできる”

Sora 2の操作は「テキストを入力して待つ」——それだけ。

もう編集ソフトを開く必要はありません。

大切なのは、どんな映像を思い描くか=プロンプトの設計です。

💬 Sora 2は“AIに動画を作ってもらうツール”ではなく、

“あなたの頭の中の映像を再現してくれるツール”。

実際に作ってみた:屋上でダンスバトルする猫

Sora 2の理解力を確かめるために、私が最初に試したテーマはもちろん――猫。

舞台は夕暮れの屋上。

2匹の猫が音楽に合わせてダンスバトルを繰り広げる、という“動きと光の表現”が鍵になるシーンを選びました。

🎬 使用したプロンプト全文

🕒 生成時間:2分42秒

🎞 出力動画:約10秒

🐱 映像の印象とAIの表現力(短縮版)

生成された映像を見た瞬間、思わず「これ、本当にAIなの?」と声が出ました。

特に光・動き・カメラワークの自然さが際立っていました。

光と毛並みのリアルさ

夕暮れのオレンジにネオンの紫が重なり、猫の毛に柔らかく反射。

黒トラ猫と三毛猫の毛並みが光をまとい、立体感のある映像になっています。

カメラワークと動き

低いアングルから2匹を追う構図で、パンやズームの動きがとても滑らか。

ジャンプやターンの間合いも自然で、“演出を理解している”ような仕上がりでした。

改善点

一部で前脚の動きが硬く見えたり、光がちらつく場面もありますが、

全体としてはAIが照明と構図を理解して動かしていると感じられる完成度。

🎞️ Sora 2は「猫を動かすAI」ではなく、

“猫の世界を撮るAI”に進化したと言ってよいでしょう。

“偶然のベストテイク”を探す感覚に近くなります。

💡 生成AIとしての進化を実感

初代Soraのころは、5秒前後の映像を「動かしてみる」段階でした。

しかしSora 2では、**映像の“語り方”**が変わりました。

単に動くのではなく、カメラ・照明・キャラクターの動きが一体化して、

「情景として伝わる」動画になっています。

これは単なる技術進化ではなく、

AIが“監督の意図”を読み取れるようになった証拠だと感じます。

🎞️ 比較してみよう

同じ猫モチーフでも、初代Soraで作った「虹色の泡を追いかけてジャンプする猫」と比べると、

Sora 2では動きに重みがあり、カメラが“撮っている感覚”を持っています。

映像の質感だけでなく、“伝わる物語”の精度がまったく違います。

🎤 まとめ:AIが「監督の指示」を理解する時代へ

Sora 2を使って感じたのは、

AIが「絵」ではなく「演出」を作れるようになったということです。

日本語でも細かい描写を理解し、

照明・構図・感情の流れまで再現する。

もはや「AIに作ってもらう」ではなく、

「AIと一緒に撮る」感覚に近づいています。

💡 よくあるつまずきと改善のコツ

Sora 2は操作がシンプルなぶん、ちょっとした書き方の違いで結果が大きく変わることがあります。

ここでは、実際に試して分かった“よくあるつまずき”と、その改善方法を紹介します。

① 映像が暗すぎる・明るすぎる

原因:

Sora 2は光源や時間帯を自動的に解釈しますが、

「夕暮れ」「夜」などの指定があると極端に暗くなる場合があります。

改善策:

- 暗いとき →

well-lit,under warm sunset light,soft lighting - 明るすぎるとき →

dimly lit,soft shadows,low contrast lighting - 日本語なら:「柔らかい光」「やさしい照明」などを追加

💡 光の描写はSora 2が最も得意とする要素。

具体的に指示すると劇的に映像が改善します。

② 動きがぎこちない・カメラが揺れる

原因:

動作の種類が多すぎると、AIが動きを統合しきれず不自然になります。

改善策:

- 動作は1〜3種類に絞る(例:ステップ→スピン→ハイタッチ)

- カメラの動きを指定する

→smooth camera movement,steady shot,slow motion - 日本語なら:「カメラはゆっくりと動き」「スローモーションで」

🎥 ポイント:

「動きを抑える」よりも「滑らかにする」と表現するほうが自然に仕上がります。

③ 構図が思っていたのと違う

原因:

AIがシーン全体を“自由に解釈”するため、主題がずれることがあります。

改善策:

- 被写体を明確に:「only two cats」「on a rooftop」「no humans」

- カメラの位置を指定:「from below」「close-up」「wide shot」

- 背景を限定:「with city lights」「under the sunset sky」

🐾 一文の中で「どこで」「誰が」「何をする」を明確に。

書きすぎよりも“絞り込み”のほうが成功率が上がります。

④ 生成が途中で止まる・エラーが出る

原因:

混雑時や長すぎる指示文(300文字以上)で処理がタイムアウトすることがあります。

改善策:

- 一度に描く内容を減らす(15秒以下の映像に収める)

- 再試行する場合は3〜5分置いて再生成

- シーンを分けて複数回に生成し、あとで動画編集でつなぐ

🔄 生成AIは“確率的”なモデル。

同じプロンプトでも毎回少しずつ違う映像が出るので、

「リトライしてベストを選ぶ」のがコツです。

⑤ 日本語がうまく伝わらないとき

原因:

主語や動詞が曖昧な日本語は、AIが「誰が何をしたか」を誤解することがあります。

改善策:

- 主語を明示:「黒トラ猫が」「三毛猫が」

- 動作を具体化:「ステップを踏む」「ジャンプする」

- 感情を追加:「楽しそうに」「挑戦的に」

💬 “映像としての日本語”を意識すると精度が上がります。

翻訳せず、自分の言葉で演出を指示するのがベスト。

🎯 まとめ:AIに「曖昧さ」を残さない

Sora 2は、曖昧な部分を想像で補ってくれる優秀な監督ですが、

逆にその自由度が“ズレ”を生むこともあります。

映像の失敗は、たいてい「言葉の抜け」や「指示の過多」が原因。

🔑 ポイントは、“1本のカメラで撮るつもりで書く” こと。

誰を、どの距離で、どんな光で、どう終わるのか――

それを意識すると、Sora 2は驚くほど正確に応えてくれます。

⚖️ Sora 2と他の動画生成AIを比べてみた

Sora 2の登場で、AIによる動画生成は一気に身近になりました。

ただし、同じようなツールは他にもいくつか存在します。

ここでは、現在よく使われている3つのサービス──Runway、Pika、Kling──とSora 2を比較しながら、

それぞれの特徴と使い分けのポイントを整理します。

🎬 Runway(Gen-2)

特徴:

映像制作のプロや映像編集者向けに作られたツール。

生成AIに加えて、編集・補正機能が非常に充実しています。

得意なこと:

- 生成した動画をそのままカット編集・色調補正できる

- グリーンバック合成やテキストアニメーションなども可能

- YouTubeや広告用素材の制作に強い

弱点:

- 操作画面がやや複雑で、英語UIに慣れが必要

- 動画生成に時間がかかることがある

🎯 向いている人

「AIで作った素材を自分の手で仕上げたい」映像クリエイター。

🎨 Pika Labs

特徴:

SNSショート動画やアニメーション風クリップの生成が得意。

テンポの良い演出と、数秒で出るスピード感が魅力です。

得意なこと:

- アニメ調・イラスト調・スタイライズされた動画生成

- テキストアニメーション・ループ動画に強い

- UIが直感的で、初心者でもすぐ使える

弱点:

- 動画の長さは短く(5〜8秒程度)

- 実写的な質感や複雑な動きは苦手

🎯 向いている人

SNS投稿やショート動画で「テンポ重視・遊び心重視」の人。

🎥 Kling(クリング)

特徴:

中国発の高精細動画生成AIで、リアルな質感と人物動作の再現度に強み。

一部では“実写に最も近いAI”とも言われています。

得意なこと:

- 写実的な風景や人物表現

- 反射・光・影の処理が極めて精密

- 物理的な動作(歩く・跳ねるなど)の再現が自然

弱点:

- 現時点ではアクセス制限が多く、日本からの利用が不安定

- 英語/中国語UI中心で操作説明が少ない

🎯 向いている人

「リアルな人物映像」や「シネマティック表現」を追求したいユーザー。

🧠 Sora 2(OpenAI)

特徴:

ChatGPTと同じアカウントで使え、言葉の理解力が圧倒的に高いのが最大の強み。

文章で“演出意図”を伝えると、照明・カメラワーク・感情の流れまで再現します。

得意なこと:

- ストーリー性のある映像(導入→展開→オチ)

- 音・照明・動きの自然な一体化

- 日本語でも高精度に動作(翻訳不要)

弱点:

- 動画生成に数分かかる(平均2〜3分)

- 長尺(20秒以上)や複数シーン構成はまだ制限あり

🎯 向いている人

“言葉で世界を作りたい”表現者や、物語的な映像を作る人。

📊 比較表まとめ

| 項目 | Sora 2 | Runway | Pika | Kling |

|---|---|---|---|---|

| 操作の手軽さ | ◎ | △ | ◎ | △ |

| 実写感 | ○ | ○ | △ | ◎ |

| 編集機能 | △ | ◎ | ○ | △ |

| ストーリー再現 | ◎ | ○ | △ | ○ |

| 日本語対応 | ◎ | ○ | ○ | △ |

| 無料枠の有無 | ○ | △ | ○ | △ |

💬 使い分けの考え方

- Pika:遊び感覚でショート動画を作る

- Runway:生成後に細かく編集したい

- Kling:リアルな質感・人物中心の映像を狙う

- Sora 2:言葉から“物語”を作る

Sora 2は、これらの中でも“総合演出型”のAIです。

ChatGPTの文脈理解を引き継ぎ、物語・動作・照明・感情の流れを同時に構築できる点で独自の存在。

つまり、「映像の脚本を書ける人」ほどSora 2を活かせる、そんなツールになっています。

まとめ&次作アイデア

Sora 2を使って感じたのは、

「映像制作が、いよいよ“言葉の世界”にやってきた」ということです。

これまで動画を作るには、カメラ・照明・編集ソフト・BGMなど、

多くの工程やスキルが必要でした。

でも、Sora 2ではそのすべてを文章で描ける。

あなたの頭の中にあるシーンを言葉で伝えるだけで、

AIが光・音・動きまでを解釈してくれる時代が始まりました。

🐾 実際に使ってみてわかったこと

今回の「屋上でダンスバトルする猫」は、

“遊び心”で書いたつもりのプロンプトでした。

それでもSora 2は、猫たちの表情、照明の反射、

スローモーションの演出まできちんと理解し、

物語として成立する映像を作り出しました。

しかも、日本語だけでここまで自然に表現できたのは大きな進化。

英語の構文を意識しなくても、

“映像として伝わる日本語”を書けば十分通じる――

これは創作にとって、とても大きな自由です。

💡 これからの可能性

Sora 2はまだ開発途上のAIですが、

すでに映像制作のハードルを劇的に下げています。

SNSやブログでの短編動画はもちろん、

教育・広告・アートの領域にも広がっていくでしょう。

たとえば、文章で絵コンテを描く時代。

脚本家やライターが、そのまま“映像を監督できる時代”が近づいています。

🐱 次作アイデア:猫シリーズをもっと広げてみる

せっかくなので、次は少し違う舞台で猫たちを登場させてみようと思います。

Sora 2なら、どんなテーマでも数分で世界を作ってくれます。

| タイトル案 | シーンイメージ |

|---|---|

| 雪の中でスノーボードする猫 | 白銀の世界でふわっとジャンプ。スローモーションが映える。 |

| 図書館で本を読む猫 | ランプの光の下、ページをめくる静かな時間。 |

| カフェでバリスタをする猫 | ミルクフォームをハートに描く“猫バリスタ”。 |

| 宇宙服を着た猫の月面散歩 | 無重力の動きと地球の青。SF調の演出で。 |

どれも短いクリップで成立する題材です。

プロンプトの構成を工夫すれば、

“1本の短編アニメ”のような映像シリーズも作れそうです。

🎬 おわりに

Sora 2は、AIが人の想像力を奪うツールではなく、

人の想像力を映像として解放するツールです。

AIがあなたの代わりに作るのではなく、

あなたの頭の中を一緒に“撮ってくれる”。

そんな感覚を、久しぶりに味わいました。

🐾 「次は、あなたの猫がどんな世界で踊るのか?」

その答えは、もう数行のテキストの中にあります。

💡 同じカテゴリーの関連記事です(近いテーマを優先しています)